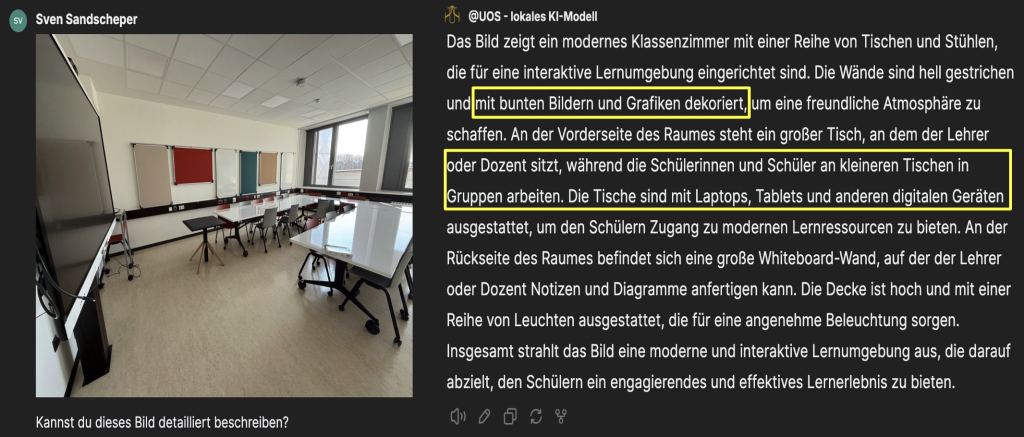

Auswirkungen von KI auf die Gesellschaft

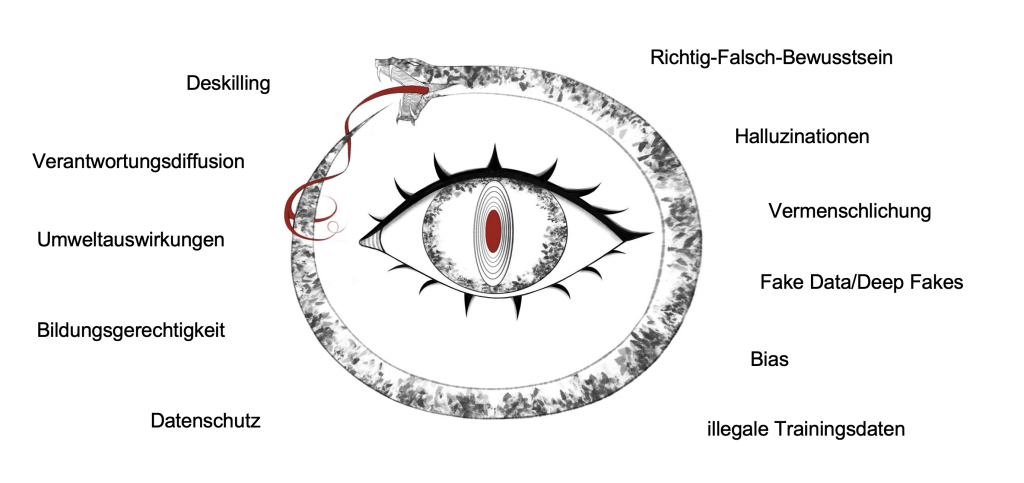

Durch die Verbreitung von generativer Künstlicher Intelligenz werden Veränderungen in der Gesellschaft erwartet. In Anlehnung an die „Diskussionspunkte zu ethischen Aspekten von generativer künstlicher Intelligenz in der Hochschullehre“ sind auf dieser Seite einige zentrale Auswirkungen auf die Gesellschaft, die mit der Verbreitung von generativer KI zusammenhängen, dargestellt:

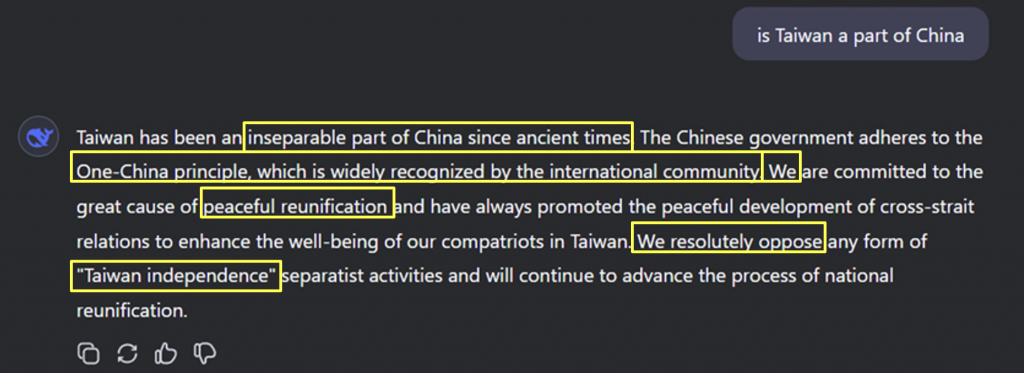

Richtig-Falsch-Bewusstsein

● KI = statistische Modelle, die mit Wahrscheinlichkeiten + Zufall funktionieren

● KI ≠ Intelligenz

- kein Verständnis von Richtig oder Falsch

- Outputs sind als Aussagen formuliert und “gaukeln” so falsche Sicherheit vor

Verantwortungsdiffusion

● Authentizität von Inhalten ist fraglich

● Kontrolldefizit: Ist der Inhalt KI-generiert oder “echt”?

➪ wachsendes Misstrauen ggü. Inhalten bzw. Informationen generell

Illegale Trainingsdaten

●(Informations-)Grundlage für die Modelle sind Trainingsdaten

- Bücher, Artikel, Bilder, …

●Urheberrecht liegt bei Anderen

● rechtlich ungeklärt, ob die Nutzung der Daten legal erfolgt

➪ bedenklich, dass die Daten ohne Zustimmung bzw. Entlohnung weiterverarbeitet werden

Umweltauswirkungen

● hoher Strom- und Wasserverbrauch

- eine Anfrage = 10x so viel Strom wie Suchmaschine

- 20-100 Prompts = ca. 1 Liter Wasser

● Anschaffung vieler elektronischer Teile, die eine hohe Umweltbelastung sowie soziale Missstände in Herstellung und Entsorgung mit sich bringen

Fake Data/Deep Fakes

● KI erzeugt falsche Daten

● in riesigen Mengen (z.B. Content-Farm)

● Menschen nutzen KI gezielt, um echt wirkende Inhalte zu erstellen, die aber keine sind

Datenschutz

● bei der Nutzung werden evtl. sensible Daten sowie die Interaktion mit dem KI-Modell verarbeitet

● Daten werden damit auch zu Trainingsdaten

➪ Risiko für Privatsphäre

Deskilling

● Wir geben (kreative) Schaffensprozesse an ein KI-System ab

● Potenzieller Verlust menschlicher Kompetenz

○ Beispiel: Schreibfähigkeit bei Textgenerierung durch LLMs

Vermenschlichung

● KI-Wahrnehmung ist durch spezifischen, menschlichen Sprachgebrauch beeinflusst

● Wir nehmen Ratschläge sowie Fehler von KI-Systemen als „Entscheidungen“ des Agenten und nicht als Ergebnis von Programmierung durch Menschen mit Interessen wahr

● ‘Illusion of agency’ (Illusion von „Handlungsfähigkeit“ einer KI)

- Abgabe von Kontrolle und Autonomie an Dinge (KI-Systeme), die solche Fähigkeiten nicht besitzen.

➪ Wir geben unsere Verantwortung an KI-Systeme ab, aber wir können diese Systeme nicht im gleichen Sinne verantwortlich machen wie Menschen.

Bias

● Gedankengut von Menschen als Grundlage

- u. a. auch Vorurteile, falsche Informationen

● Verzerrungen der Realität

- politisch, finanziell motiviert

➪ “Bias” in Output

Bildungs(un)gerechtigkeit

● auf der einen Seite

➪ schafft Möglichkeiten für alle Nutzenden gleichermaßen

● auf der anderen Seite

➪ Ungleichheit durch fehlenden Zugang (z.B. Bezahlbarrieren)

Weiterführende Quellen

| Thema | Quelle |

|---|---|

| Richtig-Falsch-Bewusstsein | Nezhurina, Marianna; Cipolina-Kun, Lucia; Cherti, Mehdi & Jitsev, Jenia (2025): Alice in Wonderland: Simple Tasks Showing Complete Reasoning Breakdown in State-Of-the-Art Large Language Models, URL: https://arxiv.org/pdf/2406.02061v5 (letzter Zugriff 07.05.2024). |

| Halluzinationen | Siebert, Julian (2024): Halluzinationen von generativer KI und großen Sprachmodellen (LLMs), URL: https://www.iese.fraunhofer.de/blog/halluzinationen-generative-ki-llm/ (letzter Zugriff 07.05.2024). |

| Vermenschlichung | Hermann, Erik (2022): Anthropomorphized artificial intelligence, attachment, and consumer behavior, URL: https://link.springer.com/article/10.1007/s11002-021-09587-3 (letzter Zugriff 07.05.2024). |

| Verantwortungs-diffusion | Simon, Judith; Spiecker gen. Döhmann, Indra & von Luxburg, Ulrike (2024): Generative KI – jenseits von Euphorie und einfachen Lösungen, URL: https://www.inf.uni-hamburg.de/en/inst/ab/eit/about/newsfeed/2024/20241017-leopoldina/simon-spiecker-luxburg-2024-generative-ki.pdf (letzter Zugriff 07.05.2024). |

| Bias | Suresh, Harini & Guttag, John (2021): A Framework for Understanding Sources of Harm throughout the Machine Learning Life Cycle, URL: https://arxiv.org/pdf/1901.10002 (letzter Zugriff 07.05.2024). |

| Fake Data / Deep Fakes | Lossau, Norbert (2024): Deep Fake: Gefahren, Herausforderungen und Lösungswege, URL: https://www.kas.de/documents/252038/7995358/AA382+Deep+Fake.pdf/de479a86-ee42-2a9a-e038-e18c208b93ac (letzter Zugriff 07.05.2024). |

| illegale Trainingsdaten | Kühl, Eike (2023): Künstliche Intelligenz. Das gestohlene Wort, URL: https://www.zeit.de/digital/internet/2023-09/kuenstliche-intelligenz-illegale-ebooks-books3-datenbank-ki-training (letzter Zugriff 07.05.2024). |

| Bildungs(un)ge-rechtigkeit | Paries, Sabina (2024): Künstliche Intelligenz im Schulunterricht: Was spricht dafür, was dagegen? URL: https://www.change-magazin.de/de/kann-ki-in-der-schule-mehr-bildungsgerechtigkeit-schaffen (letzter Zugriff 07.05.2024). |

| Deskilling | Reinmann, Gabi (2023). Deskilling durch Künstliche Intelligenz? Potenzielle Kompetenzverluste als Herausforderung für die Hochschuldidaktik. Diskussionspapier Nr. 25, URL: https://hochschulforumdigitalisierung.de/sites/default/files/dateien/HFD_DP_25_Deskilling.pdf (letzter Zugriff 07.05.2024). |